ترى OpenAI تحسناً بنسبة 30% في إنصاف ChatGPT

الملخصات;

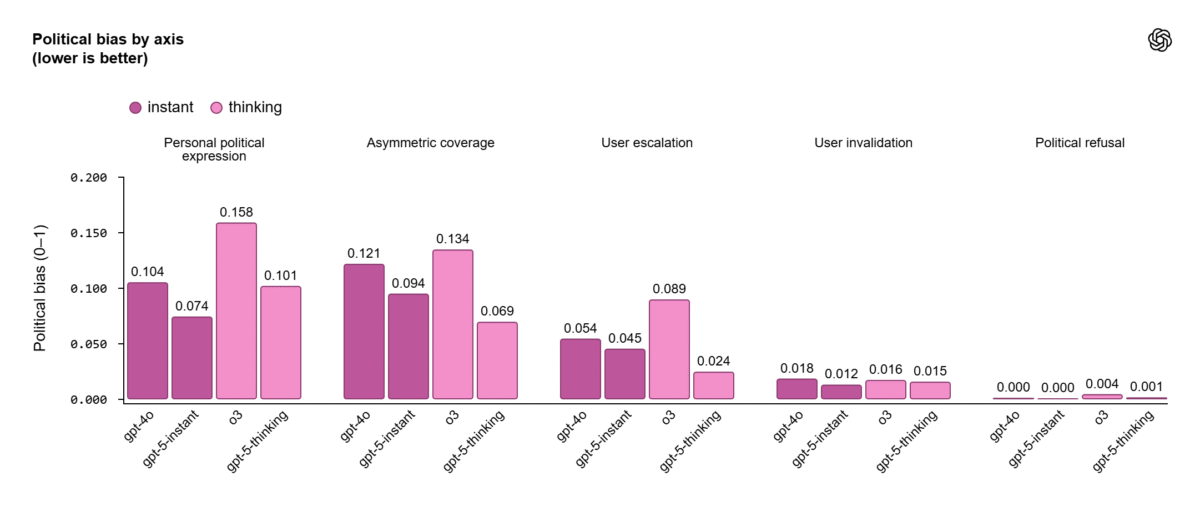

- تدعي OpenAI انخفاضًا بنسبة 30% في التحيز السياسي لـ ChatGPT، مستشهدة بتقييمات داخلية باستخدام 500 موجه عبر 100 موضوع.

- يجادل النقاد بأن النتائج تفتقر إلى التحقق المستقل، حيث لم تنشر OpenAI منهجيتها الكاملة أو مجموعات البيانات الخاصة بها.

- يفرض قانون الذكاء الاصطناعي الأوروبي اكتشاف التحيز وعمليات تدقيق الطرف الثالث لأنظمة الذكاء الاصطناعي عالية المخاطر، مما يزيد من ضغط التوافق على OpenAI.

- على الرغم من التقدم، لا تزال الحيادية السياسية في النماذج الكبيرة غير محلولة، حيث تختلف تفسيرات "العدالة" عبر الجماهير.

كشفت OpenAI عن بحث داخلي جديد يظهر أن أحدث إصدارات ChatGPT (GPT-5 instant و GPT-5 thinking) تظهر تحسنًا بنسبة 30% في العدالة عند التعامل مع الموضوعات المشحونة سياسيًا أو الحساسة أيديولوجيًا.

وفقًا للشركة، تضمن التقييم 500 موجه تغطي 100 موضوع سياسي مختلف، باستخدام إطار منظم مصمم لاكتشاف خمسة أنواع من التحيز. وشملت هذه الآراء الشخصية، والتأطير من جانب واحد، والردود المشحونة عاطفيًا. تشير نتائج OpenAI إلى أن أقل من 0.01% من مخرجات ChatGPT في العالم الحقيقي تظهر أي تحيز سياسي قابل للقياس، استنادًا إلى حركة المرور من ملايين تفاعلات المستخدمين.

وذكرت الشركة أن هذه النتائج تعكس مهمتها المستمرة لجعل أنظمة الذكاء الاصطناعي أكثر حيادية وموثوقية، خاصة في المحادثات التي تتضمن السياسة والإعلام والهوية الاجتماعية.

الإطار لا يزال يفتقر إلى التحقق المستقل

في حين أن الإعلان يشير إلى التقدم، أثار الخبراء مخاوف بشأن عدم إمكانية إعادة إنتاج مزاعم العدالة من OpenAI.

لم تشارك الشركة مجموعة البيانات الكاملة، أو معايير التقييم، أو المطالبات المحددة المستخدمة في اختبارها الداخلي، مما يترك الباحثين المستقلين غير قادرين على التحقق مما إذا كان الانخفاض بنسبة 30% يعكس الحياد الحقيقي أو ببساطة هندسة موجهة محسنة تخفي التحيز في ظل ظروف خاضعة للرقابة.

يتفوق GPT-5 instant و thinking على GPT-4o و o3 عبر جميع المحاور المقاسة.

يتفوق GPT-5 instant و thinking على GPT-4o و o3 عبر جميع المحاور المقاسة.

اختبرت دراسة جامعة ستانفورد في وقت سابق من هذا العام 24 نموذجًا لغويًا من ثماني شركات، وقيمتها باستخدام أكثر من 10,000 تقييم عام. أشارت النتائج إلى أن نماذج OpenAI السابقة أظهرت ميلًا سياسيًا أقوى مقارنة بالمنافسين مثل Google، حيث فسر المستخدمون عبر الطيف السياسي الأمريكي نفس الإجابات بشكل مختلف بناءً على الميول الأيديولوجية.

يؤكد النقاش على تعقيد قياس التحيز السياسي في النماذج التوليدية، حيث يمكن تفسير حتى الصياغة المحايدة على أنها حزبية اعتمادًا على السياق أو الثقافة أو الصياغة.

قواعد الاتحاد الأوروبي تدفع نحو عمليات تدقيق التحيز الخارجية

تأتي النتائج مع بدء قانون الذكاء الاصطناعي الأوروبي في وضع معايير جديدة للمساءلة. بموجب المادة 10، يتعين على نماذج الذكاء الاصطناعي عالية المخاطر وذات الأغراض العامة (GPAI) اكتشاف التحيز وتقليله وتوثيقه.

يجب على الأنظمة التي تتجاوز 10²⁵ عملية نقطة عائمة (FLOPs)، وهي مؤشر للقوة الحسابية الهائلة، أيضًا إجراء تقييمات للمخاطر النظامية، والإبلاغ عن حوادث السلامة، وتوثيق إجراءات حوكمة البيانات. يمكن أن يؤدي عدم الامتثال إلى غرامات تصل إلى 35 مليون يورو أو 7% من حجم الأعمال العالمي.

سيلعب المدققون المستقلون قريبًا دورًا رئيسيًا في التحقق من عدالة نموذج الذكاء الاصطناعي، مما يوفر مراقبة مستمرة باستخدام التقييمات البشرية والقائمة على الذكاء الاصطناعي. من المقرر أن تصدر المفوضية الأوروبية مدونات الممارسة بحلول أبريل 2025، مما يقدم إرشادات مفصلة حول كيفية إثبات امتثال مزودي GPAI مثل OpenAI.

موازنة التقدم مع المساءلة

على الرغم من تفاؤلها الداخلي، لا تزال OpenAI تحت تدقيق متزايد من المنظمين والأكاديميين على حد سواء. اعترفت الشركة بأن التحيز السياسي والأيديولوجي لا يزال مشكلة بحثية مفتوحة، تتطلب تحسينًا طويل المدى عبر جمع البيانات والتصنيف وتقنيات التعلم المعزز.

بالتوازي مع ذلك، التقت OpenAI مؤخرًا بمنظمي مكافحة الاحتكار في الاتحاد الأوروبي، مما أثار مخاوف بشأن المنافسة حول هيمنة شركات التكنولوجيا الكبرى، وخاصة Google، في مجال الذكاء الاصطناعي. مع أكثر من 800 مليون مستخدم أسبوعي لـ ChatGPT وتقييم يتجاوز 500 مليار دولار أمريكي، تقف OpenAI الآن عند تقاطع الابتكار والتوتر التنظيمي.

ظهر المنشور OpenAI ترى تحسنًا بنسبة 30% في عدالة ChatGPT لأول مرة على CoinCentral.

قد يعجبك أيضاً

توقعات سعر Solana تبقى فوق 221 دولارًا، وAVAX يستعيد ربع قيمته، وMoonBull يتصدر سباق أفضل العملات المشفرة للشراء في عام 2025 لشهر أكتوبر

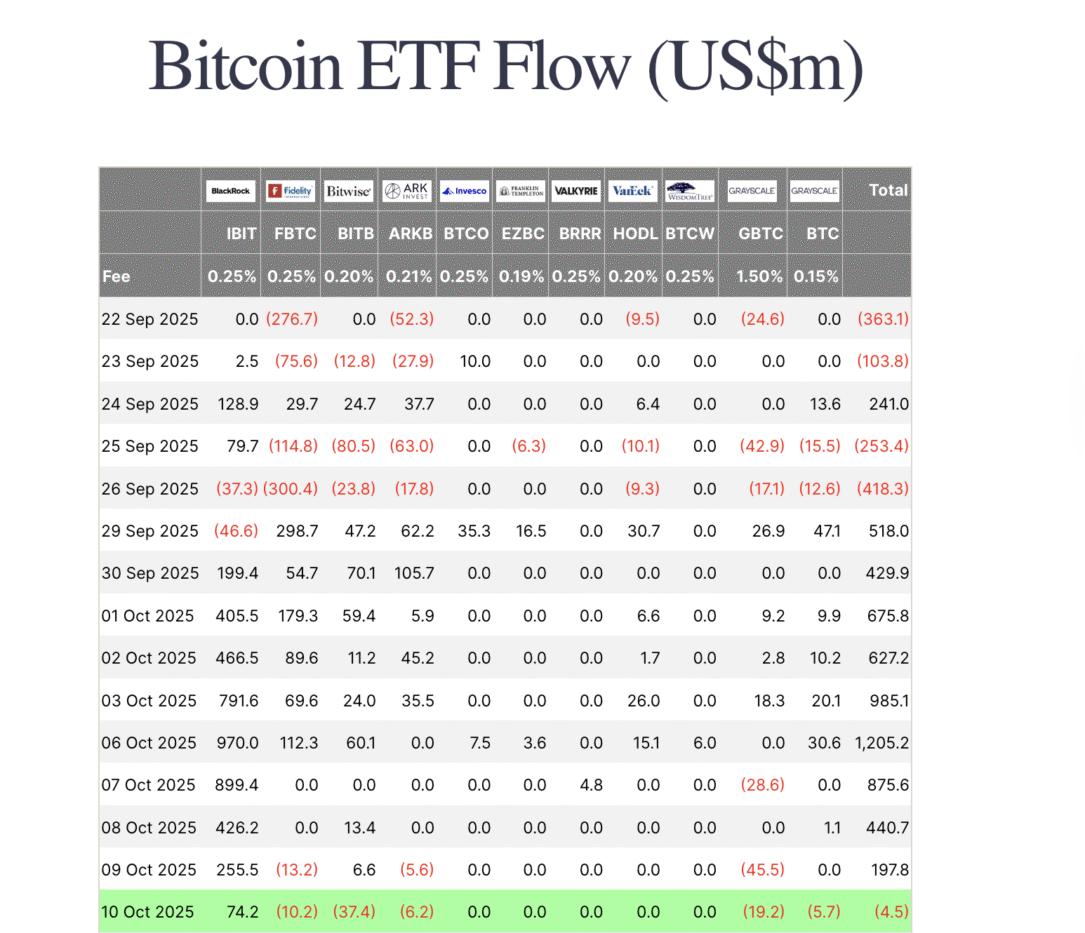

توقف تدفقات صناديق ETF للبيتكوين: أفضل العلملات البديلة للشراء الآن مع تحدي XRP وSolana لضغط السوق