Superando el Fine-Tuning Completo con Solo el 0,2% de los Parámetros

Tabla de enlaces

Resumen y 1. Introducción

-

Antecedentes

2.1 Mezcla de expertos

2.2 Adaptadores

-

Mezcla de adaptaciones

3.1 Política de enrutamiento

3.2 Regularización de consistencia

3.3 Fusión de módulos de adaptación y 3.4 Compartición de módulos de adaptación

3.5 Conexión con redes neuronales bayesianas y ensamblado de modelos

-

Experimentos

4.1 Configuración experimental

4.2 Resultados clave

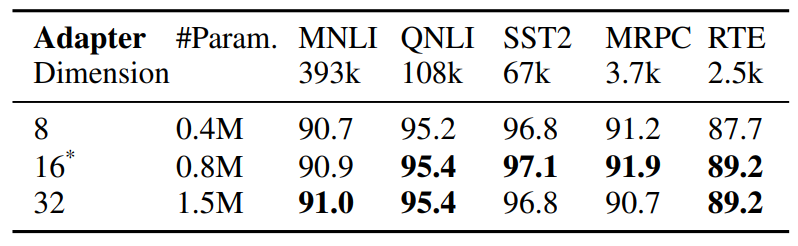

4.3 Estudio de ablación

-

Trabajo relacionado

-

Conclusiones

-

Limitaciones

-

Agradecimientos y Referencias

Apéndice

A. Conjuntos de datos NLU de pocos ejemplos B. Estudio de ablación C. Resultados detallados en tareas NLU D. Hiperparámetros

5 Trabajo relacionado

Ajuste fino eficiente en parámetros de PLMs. Los trabajos recientes sobre ajuste fino eficiente en parámetros (PEFT) pueden categorizarse aproximadamente en dos

\

\ categorías: (1) ajuste de un subconjunto de parámetros existentes, incluyendo ajuste fino de cabecera (Lee et al., 2019), ajuste de términos de sesgo (Zaken et al., 2021), (2) ajuste de parámetros recién introducidos incluyendo adaptadores (Houlsby et al., 2019; Pfeiffer et al., 2020), prompt-tuning (Lester et al., 2021), prefixtuning (Li y Liang, 2021) y adaptación de bajo rango (Hu et al., 2021). A diferencia de trabajos anteriores que operan en un solo módulo de adaptación, AdaMix introduce una mezcla de módulos de adaptación con enrutamiento estocástico durante el entrenamiento y fusión de módulos de adaptación durante la inferencia para mantener el mismo costo computacional que con un solo módulo. Además, AdaMix puede usarse sobre cualquier método PEFT para mejorar aún más su rendimiento.

\ Mezcla de expertos (MoE). Shazeer et al., 2017 introdujeron el modelo MoE con una única red de compuertas con enrutamiento Top-k y equilibrio de carga entre expertos. Fedus et al., 2021 proponen esquemas de inicialización y entrenamiento para enrutamiento Top-1. Zuo et al., 2021 proponen regularización de consistencia para enrutamiento aleatorio; Yang et al., 2021 proponen enrutamiento k Top-1 con prototipos de expertos, y Roller et al., 2021; Lewis et al., 2021 abordan otros problemas de equilibrio de carga. Todos los trabajos anteriores estudian MoE disperso con pre-entrenamiento del modelo completo desde cero. En contraste, estudiamos la adaptación eficiente en parámetros de modelos de lenguaje pre-entrenados ajustando solo un número muy pequeño de parámetros de adaptador dispersos.

\ Promediado de pesos de modelo. Exploraciones recientes (Szegedy et al., 2016; Matena y Raffel, 2021; Wortsman et al., 2022; Izmailov et al., 2018) estudian la agregación de modelos promediando todos los pesos del modelo. (Matena y Raffel, 2021) proponen fusionar modelos de lenguaje pre-entrenados que son ajustados en varias tareas de clasificación de texto. (Wortsman et al., 2022) explora el promediado de pesos de modelo de varias ejecuciones independientes en la misma tarea con diferentes configuraciones de hiperparámetros. En contraste con los trabajos anteriores sobre ajuste fino de modelo completo, nos enfocamos en el ajuste fino eficiente en parámetros. Exploramos el promediado de pesos para fusionar pesos de módulos de adaptación que consisten en pequeños parámetros ajustables que se actualizan durante el ajuste del modelo mientras se mantienen fijos los parámetros grandes del modelo.

6 Conclusiones

Desarrollamos un nuevo marco AdaMix para el ajuste fino eficiente en parámetros (PEFT) de modelos de lenguaje pre-entrenados grandes (PLM). AdaMix aprovecha una mezcla de módulos de adaptación para mejorar el rendimiento de tareas posteriores sin aumentar el costo computacional (por ejemplo, FLOPs, parámetros) del método de adaptación subyacente. Demostramos que AdaMix funciona y mejora diferentes métodos PEFT como adaptadores y descomposiciones de bajo rango en tareas NLU y NLG.

\ Al ajustar solo el 0,1 − 0,2% de los parámetros PLM, AdaMix supera el ajuste fino de modelo completo que actualiza todos los parámetros del modelo, así como otros métodos PEFT de última generación.

7 Limitaciones

El método AdaMix propuesto es algo intensivo en cómputo ya que implica el ajuste fino de modelos de lenguaje a gran escala. El costo de entrenamiento del AdaMix propuesto es mayor que los métodos PEFT estándar, ya que el procedimiento de entrenamiento involucra múltiples copias de adaptadores. Según nuestra observación empírica, el número de iteraciones de entrenamiento para AdaMix suele estar entre 1∼2 veces el entrenamiento para métodos PEFT estándar. Esto impone un impacto negativo en la huella de carbono del entrenamiento de los modelos descritos.

\ AdaMix es ortogonal a la mayoría de los estudios existentes de ajuste fino eficiente en parámetros (PEFT) y puede potencialmente mejorar el rendimiento de cualquier método PEFT. En este trabajo, exploramos dos métodos PEFT representativos como adaptador y LoRA, pero no experimentamos con otras combinaciones como prompt-tuning y prefix-tuning. Dejamos esos estudios para trabajos futuros.

8 Agradecimientos

Los autores desean agradecer a los árbitros anónimos por sus valiosos comentarios y sugerencias útiles y desean agradecer a Guoqing Zheng y Ruya Kang por sus comentarios perspicaces sobre el proyecto. Este trabajo está respaldado en parte por la Fundación Nacional de Ciencias de EE.UU. bajo las subvenciones NSFIIS 1747614 y NSF-IIS-2141037. Cualquier opinión, hallazgo y conclusión o recomendación expresada en este material son las del autor(es) y no necesariamente reflejan los puntos de vista de la Fundación Nacional de Ciencias.

Referencias

Armen Aghajanyan, Sonal Gupta, y Luke Zettlemoyer. 2021. Intrinsic dimensionality explains the effectiveness of language model fine-tuning. In Proceedings of the 59th Annual Meeting of the Association for Computational Linguistics and the 11th International Joint Conference on Natural Language Processing (Volume 1: Long Papers), pages 7319– 7328, Online. Association for Computational Linguistics.

\ Roy Bar Haim, Ido Dagan, Bill Dolan, Lisa Ferro, Danilo Giampiccolo, Bernardo Magnini, y Idan Szpektor. 2006. The second PASCAL recognising textual entailment challenge.

\ Luisa Bentivogli, Peter Clark, Ido Dagan, y Danilo Giampiccolo. 2009. The fifth PASCAL recognizing textual entailment challenge. In TAC.

\ Tom Brown, Benjamin Mann, Nick Ryder, Melanie Subbiah, Jared D Kaplan, Prafulla Dhariwal, Arvind Neelakantan, Pranav Shyam, Girish Sastry, Amanda Askell, Sandhini Agarwal, Ariel HerbertVoss, Gretchen Krueger, Tom Henighan, Rewon Child, Aditya Ramesh, Daniel Ziegler, Jeffrey Wu, Clemens Winter, Chris Hesse, Mark Chen, Eric Sigler, Mateusz Litwin, Scott Gray, Benjamin Chess, Jack Clark, Christopher Berner, Sam McCandlish, Alec Radford, Ilya Sutskever, y Dario Amodei. 2020. Language models are few-shot learners. In Advances in Neural Information Processing Systems, volume 33, pages 1877–1901. Curran Associates, Inc.

\ Ido Dagan, Oren Glickman, y Bernardo Magnini. 2005. The PASCAL recognising textual entailment challenge. In the First International Conference on Machine Learning Challenges: Evaluating Predictive Uncertainty Visual Object Classification, and Recognizing Textual Entailment.

\ Jacob Devlin, Ming-Wei Chang, Kenton Lee, y Kristina Toutanova. 2019. BERT: pre-training of deep bidirectional transformers for language understanding. In Proceedings of the 2019 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, NAACL-HLT 2019, Volume 1 (Long and Short Papers), pages 4171–4186.

\ William Fedus, Barret Zoph, y Noam Shazeer. 2021. Switch transformers: Scaling to trillion parameter models with simple and efficient sparsity. arXiv preprint arXiv:2101.03961.

\ Jonathan Frankle, Gintare Karolina Dziugaite, Daniel Roy, y Michael Carbin. 2020. Linear mode connectivity and the lottery ticket hypothesis. In International Conference on Machine Learning, pages 3259–3269. PMLR.

\ Yarin Gal y Zoubin Ghahramani. 2015. Dropout as a bayesian approximation: Representing model uncertainty in deep learning. CoRR, abs/1506.02142.

\ Yarin Gal, Riashat Islam, y Zoubin Ghahramani. 2017. Deep Bayesian active learning with image data. In Proceedings of the 34th International Conference on Machine Learning, volume 70 of Proceedings of Machine Learning Research, pages 1183–1192. PMLR.

\ Tianyu Gao, Adam Fisch, y Danqi Chen. 2021. Making pre-trained language models better few-shot learners. In Association for Computational Linguistics (ACL).

\ Claire Gardent, Anastasia Shimorina, Shashi Narayan, y Laura Perez-Beltrachini. 2017. The webnlg challenge: Generating text from rdf data. In Proceedings of the 10th International Conference on Natural Language Generation, pages 124–133.

\ Danilo Giampiccolo, Bernardo Magnini, Ido Dagan, y Bill Dolan. 2007. The third PASCAL recognizing textual entailment challenge. In the ACLPASCAL Workshop on Textual Entailment and Paraphrasing.

\ Neil Houlsby, Andrei Giurgiu, Stanislaw Jastrzebski, Bruna Morrone, Quentin De Laroussilhe, Andrea Gesmundo, Mona Attariyan, y Sylvain Gelly. 2019. Parameter-efficient transfer learning for nlp. In International Conference on Machine Learning, pages 2790–2799. PMLR.

\ Edward J Hu, Yelong Shen, Phillip Wallis, Zeyuan Allen-Zhu, Yuanzhi Li, Shean Wang, Lu Wang, y Weizhu Chen. 2021. Lora: Low-rank adaptation of large language models. arXiv preprint arXiv:2106.09685.

\ Pavel Izmailov, Dmitrii Podoprikhin, Timur Garipov, Dmitry Vetrov, y Andrew Gordon Wilson. 2018. Averaging weights leads to wider optima and better generalization. arXiv preprint arXiv:1803.05407.

\ Jaejun Lee, Raphael Tang, y Jimmy Lin. 2019. What would elsa do? freezing layers during transformer fine-tuning. arXiv preprint arXiv:1911.03090.

\ Dmitry Lepikhin, HyoukJoong Lee, Yuanzhong Xu, Dehao Chen, Orhan Firat, Yanping Huang, Maxim Krikun, Noam Shazeer, y Zhifeng Chen. 2020. Gshard: Scaling giant models with conditional computation and automatic sharding. arXiv preprint arXiv:2006.16668.

\ Brian Lester, Rami Al-Rfou, y Noah Constant. 2021. The power of scale for parameter-efficient prompt tuning. CoRR, abs/2104.08691.

\ Mike Lewis, Shruti Bhosale, Tim Dettmers, Naman Goyal, y Luke Zettlemoyer. 2021. Base layers: Simplifying training of large, sparse models. In ICML.

\ Xiang Lisa Li y Percy Liang. 2021. Prefixtuning: Optimizing continuous prompts for generation. CoRR, abs/2101.00190.

\ Yinhan Liu, Myle Ott, Naman Goyal, Jingfei Du, Mandar Joshi, Danqi Chen, Omer Levy, Mike Lewis, Luke Zettlemoyer, y Veselin Stoyanov. 2019. Roberta: A robustly optimized BERT pretraining approach. CoRR, abs/1907.11692.

También te puede interesar

¿Qué está impulsando la valoración de $675 millones de Avalanche?

Las tesorerías de criptomonedas podrían consolidarse a medida que aumenta la competencia, dice investigador de Coinbase