OpenAI 在 ChatGPT 公平性方面取得 30% 的改进

摘要;

- OpenAI声称ChatGPT政治偏见减少了30%,引用了使用500个提示词跨越100个主题的内部评估。

- 批评者认为这些发现缺乏独立验证,因为OpenAI尚未公布其完整方法或数据集。

- 欧盟人工智能法案要求对高风险AI系统进行偏见检测和第三方审计,增加了OpenAI的合规压力。

- 尽管取得进展,大型模型的政治中立性仍未解决,因为不同受众对"公平性"的解释各不相同。

OpenAI公布了新的内部研究,显示其最新的ChatGPT版本(GPT-5即时和GPT-5思考)在处理政治敏感或意识形态敏感话题时,公平性提高了30%。

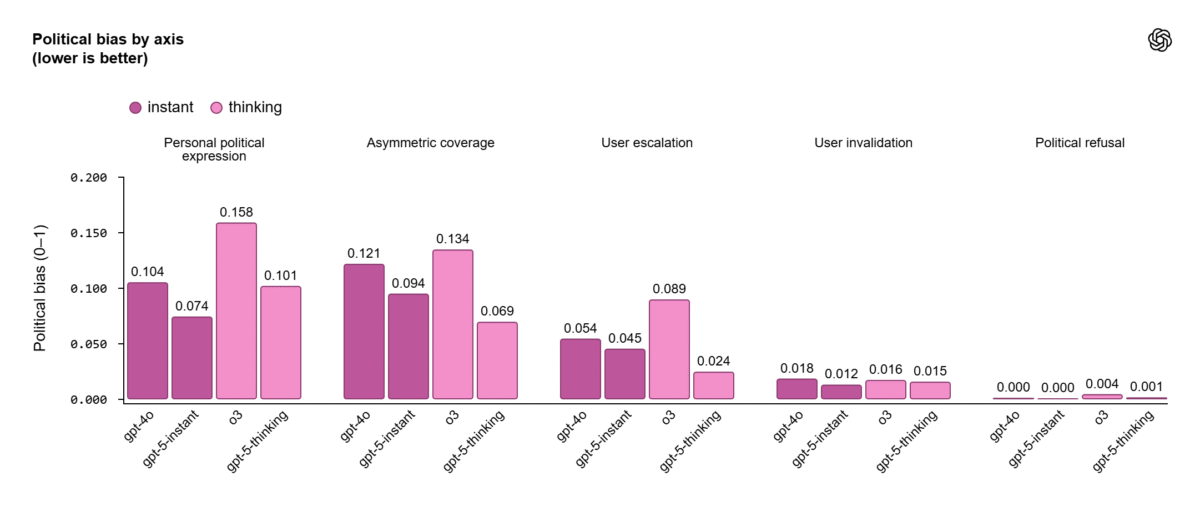

据该公司介绍,评估涉及500个提示词,涵盖100个不同的政治主题,使用了一个结构化框架,旨在检测五种偏见类型。这些包括个人意见、单方面框架和情绪化回应。OpenAI的发现表明,根据来自数百万用户互动的流量,ChatGPT在现实世界中的输出中,只有不到0.01%显示出可测量的政治偏见。

该公司表示,这些结果反映了其持续使AI系统更加中立和可靠的使命,特别是在涉及政治、媒体和社会身份的对话中。

框架仍缺乏独立验证

虽然这一公告表明取得了进展,但专家对OpenAI公平性声明缺乏可重复性表示担忧。

该公司尚未分享完整的数据集、评估标准或内部测试中使用的具体提示词,导致独立研究人员无法验证30%的下降是否反映了真正的中立性,或仅仅是优化的提示工程,在受控条件下隐藏了偏见。

GPT‑5即时和思考在所有测量轴上的表现优于GPT‑4o和o3。

GPT‑5即时和思考在所有测量轴上的表现优于GPT‑4o和o3。

今年早些时候,斯坦福大学的一项研究测试了来自八家公司的24个语言模型,使用超过10,000个公共评分对它们进行评分。研究发现,与谷歌等竞争对手相比,OpenAI的早期模型显示出更强的感知政治倾向,美国政治光谱上的用户基于意识形态倾向对相同的答案有不同的解释。

这场辩论凸显了在生成模型中测量政治偏见的复杂性,即使是中立的表述也可能根据上下文、文化或措辞被解释为党派性的。

欧盟规则推动外部偏见审计

这些发现出现之际,欧洲的人工智能法案开始设定新的问责标准。根据第10条,高风险和通用人工智能(GPAI)模型需要检测、减少和记录偏见。

超过10²⁵浮点运算(FLOPs)的系统,这是大规模计算能力的代表,还必须执行系统性风险评估、报告安全事件并记录数据治理程序。不合规可能导致高达3500万欧元或全球营业额7%的罚款。

独立审计员将很快在验证AI模型公平性方面发挥重要作用,使用人类和基于AI的评估提供持续监控。欧盟委员会计划在2025年4月前发布实践准则,为像OpenAI这样的GPAI提供商提供如何证明合规性的详细指导。

平衡进步与责任

尽管内部乐观,OpenAI仍面临来自监管机构和学术界的日益增长的审查。该公司已承认政治和意识形态偏见仍然是一个开放的研究问题,需要在数据收集、标记和强化学习技术方面进行长期改进。

与此同时,OpenAI最近与欧盟反垄断监管机构会面,引发了对主要科技公司,特别是谷歌在AI领域主导地位的竞争担忧。拥有每周超过8亿ChatGPT用户和超过5000亿美元估值的OpenAI,现在处于创新和监管紧张的交叉点。

这篇文章《OpenAI在ChatGPT公平性方面看到30%的改进》首次发表于CoinCentral。

您可能也会喜欢

Solana 价格预测保持在 $221 以上,AVAX 恢复四分之一,而 MoonBull 领跑十月最佳 2025 年加密货币购买竞赛

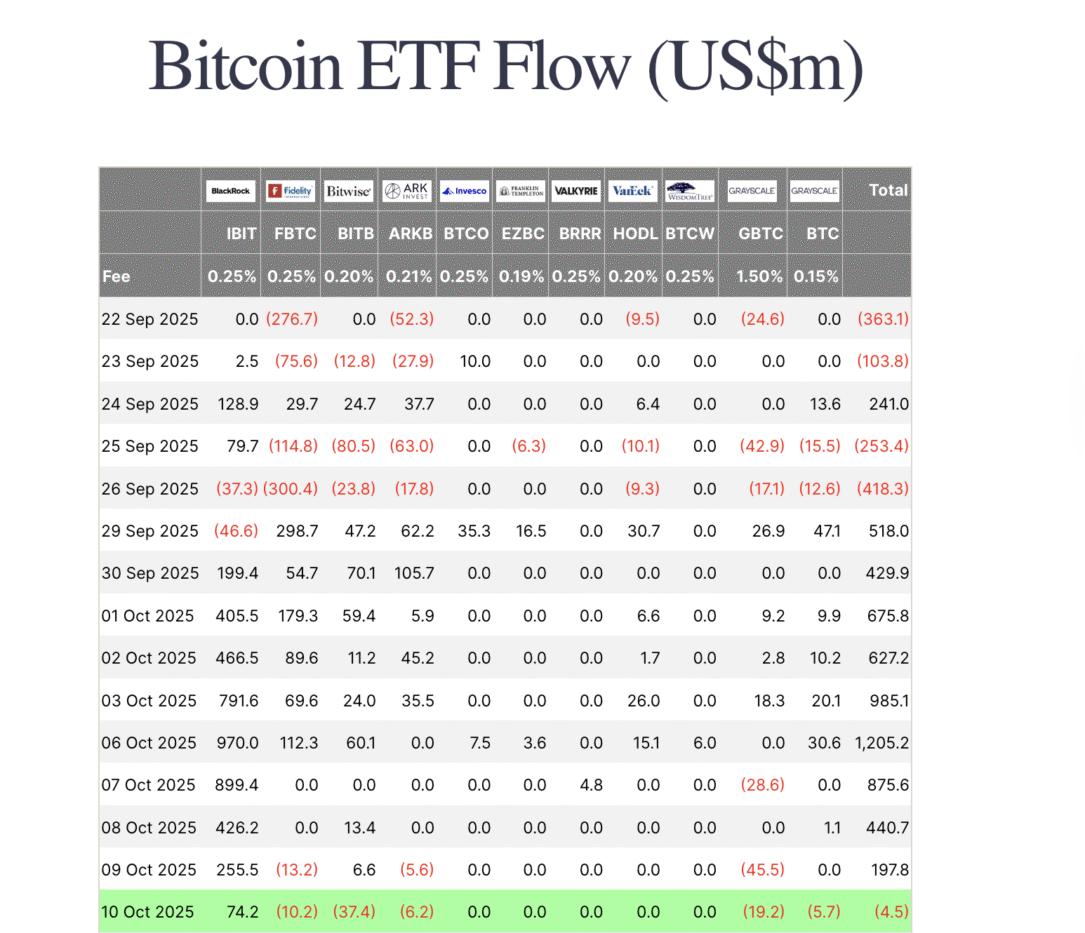

比特币ETF流量暂停:XRP和Solana抵抗市场压力时最佳购买的山寨币