L'IA fantôme est-elle pire que l'informatique fantôme ?

Un bureau calme peut sembler inoffensif. Des rangées d'écrans baignés de lumière, des écouteurs couvrant les conversations, et le bourdonnement du travail se poursuit sans aucun signe que quelque chose de sinistre se cache en dessous. Mais de plus en plus, on trouve des technologies accidentelles et non autorisées — un dossier cloud personnel ici et un chatbot d'IA non autorisé là. Bientôt, l'organisation devra gérer tous ces nouveaux risques imprévus. Mais le shadow IT n'était que la première vague de menaces cachées. Le Shadow AI a relevé les enjeux.

Qu'est-ce que le Shadow AI et pourquoi se développe-t-il

Extension du shadow IT, le shadow AI implique l'utilisation par les employés de technologies non approuvées. Le shadow IT fait généralement référence aux technologies grand public, comme les applications de partage de fichiers ou les appareils personnels. Le shadow AI implique généralement des systèmes rapides et gourmands en données dont le comportement peut être erratique.

\ Selon une étude menée par Gartner, 80% des organisations présentent des lacunes en matière de gouvernance des données. Ces lacunes facilitent le fait que les gens manquent les comportements générés par l'IA. De nombreuses équipes échouent aux évaluations de préparation à la cybersécurité. Le risque associé à l'IA est accru par les employés qui adoptent de nouveaux outils plus rapidement que leurs équipes ne peuvent les examiner de manière adéquate. Étant donné que 30% des violations de données proviennent de vendeurs ou de fournisseurs, savoir quels outils une équipe utilise est un élément essentiel pour sécuriser les actifs numériques d'une entreprise.

\ Le shadow AI a gagné du terrain car les employés considèrent le contenu généré par l'IA comme un moyen plus rapide de créer du contenu, de résumer des informations complexes et de résoudre des problèmes techniques. Il réduit les frictions dans le travail quotidien mais introduit des risques qui n'étaient pas observés auparavant avec les préoccupations liées au shadow IT, notamment l'exposition des données, le risque de conformité et les risques au niveau du modèle.

Shadow AI versus Shadow IT

Le shadow IT a longtemps été blâmé pour des vulnérabilités inconnues. Un pourcentage élevé des violations antérieures était dû à des outils SaaS non signés ou à un stockage personnel. Les outils d'IA changent complètement l'équation. L'échelle et la vitesse à laquelle ils fonctionnent, ainsi que leur opacité, créent des risques plus difficiles à détecter et à contenir.

\ Avec 78% des organisations utilisant l'IA en production, certaines violations sont désormais dues à une exposition technologique non gérée. Le modèle IT plus large compte toujours, mais l'IA introduit une nouvelle dimension pour élargir la surface d'attaque.

Différences clés entre le Shadow AI et le Shadow IT

Le shadow AI est similaire au shadow IT en ce sens que les deux découlent du désir d'un employé d'être plus productif, mais ils diffèrent quant à l'emplacement du risque.

- Les outils de shadow IT ont une logique fixe, ce qui rend le comportement prévisible. La prévision du comportement des outils de shadow AI est plus complexe car les modèles peuvent être continuellement modifiés et réentraînés.

- Les risques du shadow IT incluent le stockage ou le déplacement de données sans autorisation. Les risques du shadow AI incluent l'inversion de modèle, l'empoisonnement des données et l'entraînement de modèle.

- Le shadow IT est déterministe, tandis que les outils d'IA peuvent halluciner, mal généraliser et produire avec trop de confiance des résultats incorrects.

\ Le shadow AI apparaît également dans le contexte des réglementations à venir, comme la loi sur l'intelligence artificielle de l'UE, qui pourrait accroître la surveillance réglementaire.

Risques de sécurité qui rendent le Shadow AI plus urgent

Le shadow AI peut entraîner des problèmes en ingénierie, marketing et finance. Lorsque des décisions sont prises sur la base des résultats de l'IA, des données propriétaires peuvent être divulguées et des processus commerciaux internes peuvent être manipulés sans que personne ne s'en aperçoive.

\

- Manipulation de modèle : Les attaquants peuvent créer des données qui faussent les résultats.

- Exposition à l'injection de prompt : Un prompt créé peut être utilisé pour extraire des informations privées d'un modèle.

- Lacunes dans la lignée des données : Les outils d'IA peuvent générer et stocker des données de manière que les équipes de sécurité ne peuvent pas suivre.

- Dérive de conformité : Les outils d'IA changent, et les plans de gouvernance évolutifs peuvent devenir non pertinents.

\ La préoccupation grandit avec l'avènement de l'IA générative. Un chatbot répondant à la question d'un fournisseur ou un résumé d'IA générative peut sembler inoffensif, mais il risque de révéler des données d'utilisation sensibles ou une propriété intellectuelle propriétaire précieuse. L'Université Carnegie Mellon a constaté que les grands modèles de langage sont beaucoup plus vulnérables aux prompts adverses que les systèmes basés sur des règles. Le problème s'aggrave lorsque les employés peuvent utiliser les outils sans supervision.

\ Un arbre de décision piloté par l'IA peut être plus biaisé qu'un arbre de décision conventionnel. Le shadow AI reçoit souvent des informations de formation incomplètes introduites dans des outils tiers. Une surveillance structurée des systèmes d'IA garantirait l'intégrité des mises à jour. Lorsque les équipes négligent cela, les données et le comportement du modèle dérivent.

Comment les équipes de sécurité peuvent réduire l'exposition au Shadow AI

Bien que le shadow AI pose de nombreux risques, les organisations peuvent en atténuer beaucoup en combinant la visibilité avec des politiques et des contrôles techniques, en trouvant un équilibre qui protège la productivité des employés sans les surcharger avec des vérifications chronophages ou des sites bloqués. Les équipes de sécurité bénéficient de traiter le shadow AI comme un problème de gouvernance plutôt que comme un problème de punition. Les stratégies d'atténuation devront inévitablement évoluer à mesure que les employés utilisent des outils d'IA pour améliorer leur productivité.

1. Construire un cadre clair de gouvernance de l'IA

Un plan de gouvernance devrait spécifier quels outils d'IA approuver, quels types de données les employés peuvent utiliser, comment examiner les résultats du modèle avant de prendre des décisions à enjeux élevés, et que faire lorsqu'un comportement imprévisible du modèle se produit. Ce dernier élément comprend qui examine le comportement, qui enquête sur ses causes et quelles sont les conséquences.

\ Avec une surveillance en place, les organisations peuvent traiter l'IA comme n'importe quel autre actif d'entreprise, soumis aux mêmes responsabilités de traçabilité, d'auditabilité, de sécurité et de conformité que les autres systèmes d'entreprise existants.

2. Fournir des outils d'IA approuvés

Les équipes ayant accès à des outils d'IA vérifiés et centralisés sont moins susceptibles de se tourner vers des IA publiques non approuvées pour contourner les blocages. À mesure que les emplois deviennent plus automatisés, le personnel consacrera plus d'efforts à divers modèles. Les travailleurs passent déjà environ 4,6 heures par semaine à utiliser l'IA au travail, dépassant le temps d'utilisation personnel moyen de 3,6 heures par semaine. L'IA provenant de parties tierces, sans surveillance adéquate, pourrait déjà être plus courante que les outils d'entreprise qui sont vérifiés et approuvés. Les entreprises devraient prendre des mesures immédiates pour faire respecter leurs politiques.

\ Avec un environnement géré, les organisations peuvent surveiller l'utilisation via des outils, définir des autorisations dans les bases de données et appliquer la gouvernance des données dans tous les départements. Cela améliore la productivité des employés tout en protégeant l'intégrité des données et la conformité de l'entreprise.

3. Surveiller le mouvement des données et l'utilisation des modèles

Les outils de visibilité qui signalent un comportement anormal — comme des augmentations soudaines de l'utilisation de l'IA, le téléchargement de données vers des points de terminaison inhabituels ou l'accès au modèle dans un court laps de temps avec des données sensibles — peuvent aider les équipes de sécurité à identifier les abus et les fuites de données. Des rapports indiquent qu'au cours de l'année écoulée, jusqu'à 60% des employés ont utilisé des outils d'IA non approuvés, et 93% ont admis avoir saisi des données de l'entreprise sans autorisation.

\ La détection précoce de ces modèles peut permettre la correction, la rééducation, la reconfiguration des autorisations ou la résiliation du processus avant qu'il ne conduise à des fuites de données ou à des violations de conformité.

4. Former les employés aux risques spécifiques à l'IA

La formation générale à la cybersécurité n'est pas suffisante. L'IA peut halluciner en interprétant mal l'intention derrière les prompts et générer un contenu apparemment faisant autorité, faux ou biaisé. De plus, les travailleurs doivent comprendre que l'utilisation de l'IA diffère de l'utilisation de logiciels ou de services. Une utilisation sécurisée nécessite de changer les modèles mentaux, de comprendre les risques liés aux prompts et de gérer les données personnelles.

\ Les utilisateurs ayant une connaissance de base des machines vérifieront les faits des résultats et seront moins susceptibles de partager excessivement des données personnelles. Ils traiteront les outils comme des copilotes précieux, mais ils doivent être utilisés sous supervision humaine.

Protéger les organisations contre le Shadow AI

Le shadow AI se développe plus rapidement et est plus difficile à identifier que le shadow IT. Bien que l'échelle et la complexité des risques diffèrent, solliciter l'aide des employés peut identifier les deux plus efficacement. Les politiques de gouvernance peuvent aider les entreprises à trouver le bon équilibre. Les équipes de sécurité devraient réévaluer leur exposition, rester vigilantes face aux menaces émergentes et agir rapidement avant que des outils basés sur l'IA invisibles ne prennent des décisions cruciales dans les applications commerciales.

Vous aimerez peut-être aussi

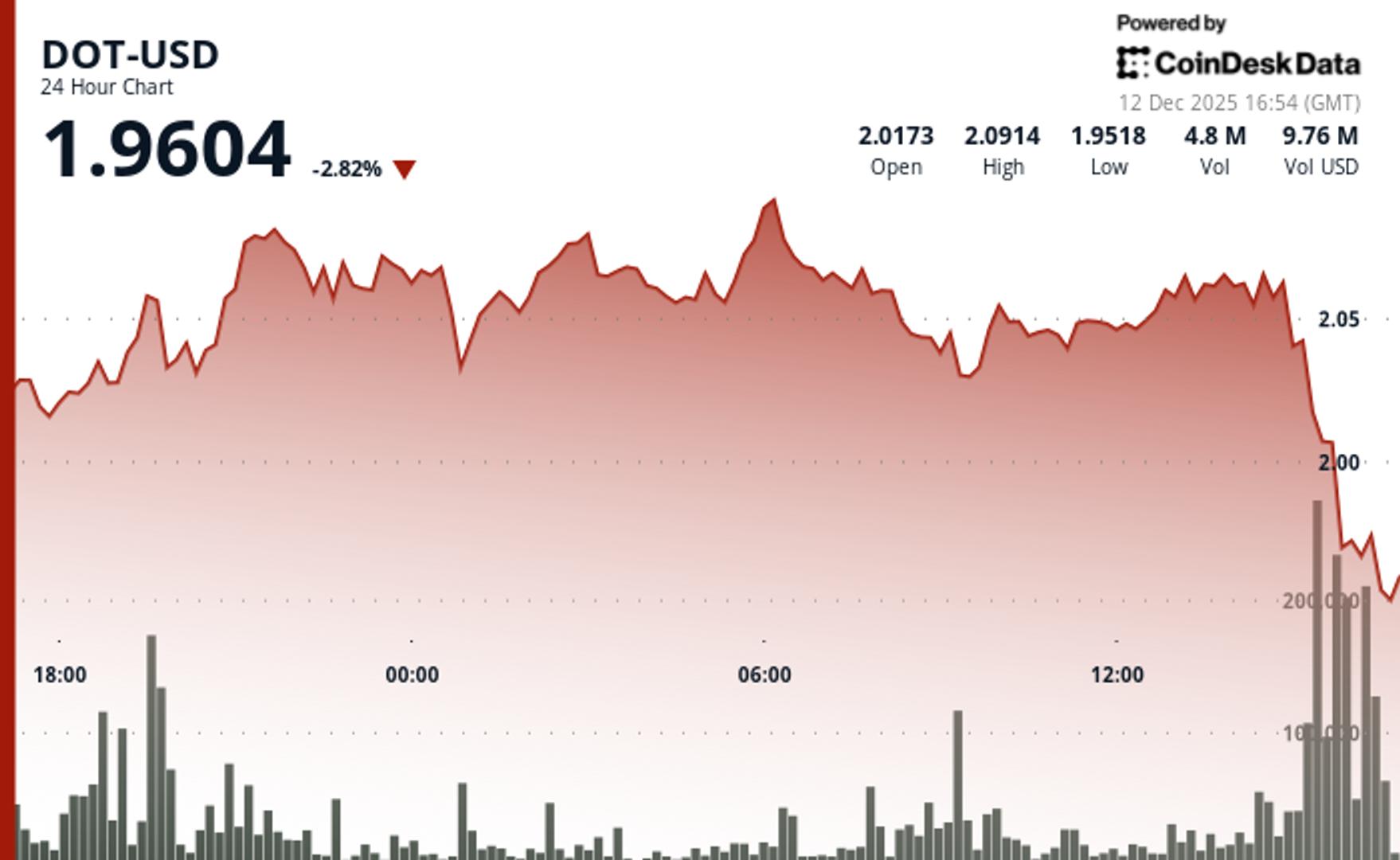

DOT Chute de 2 % Après Avoir Brisé un Support Clé

Copier le lienX (Twitter)LinkedInFacebookEmail

Garlinghouse avec une « grande nouvelle » pour Ripple : Approbation de la National Trust Bank obtenue